tibodreep | Bonjour à toutes et à tous.

Voici ma venue ici car j'ai trouvé le topic suivant : https://cutt.ly/L0mAEta qui semble se rapprocher de mon problème.

Toutefois, pour ne pas polluer le sujet, je me suis permis de créer un nouveau topic.

Quelques éléments sur ma situation :

OMV installé sur un NAS maison, sans soucis particulier semble-t-il jusque là (2-3 ans).

1 ssd système (+1 de réserve en cas de crash) + sauvegarde du système initial (si tout va bien... faut qe je remette la main dessus)

6 HDD de 2To en RAID6 (+2 en reserve en cas de crash)

Les SSD sont "neufs", les HDD pas tout jeunes.

Problème :

Je lance mon NAS et là, plus d'accès à Docker, Portainer. Je me connecte en local, je dois les reinstaller. A la réinstallation, il retrouve tous mes containers mais ngingx par exemple, tout avait sauté...

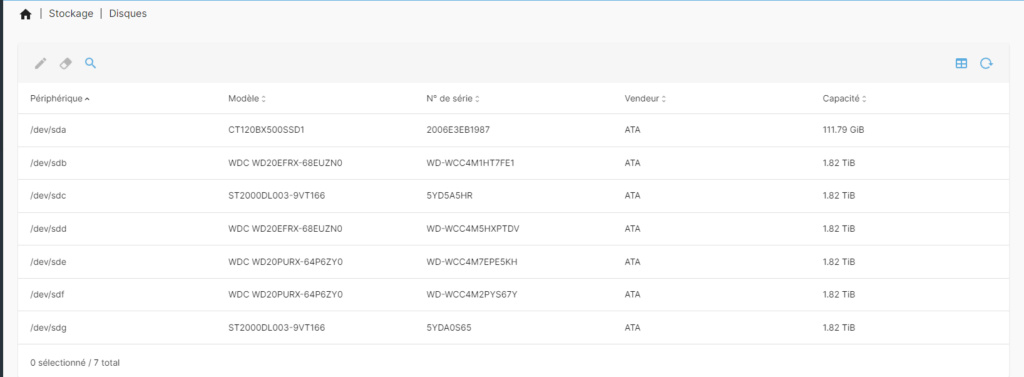

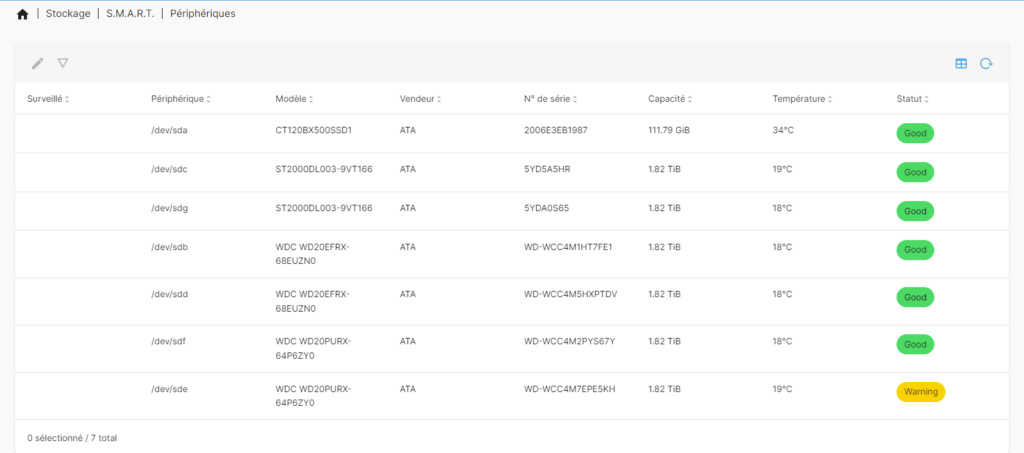

Je jette alors un oeil sur OMV plus en détail et là, plus de RAID. Ne m'est même pas proposé de récupération. Les disques dur sont bien présents et reconnus comme vous pourrez le voir sur les captures d'écran.

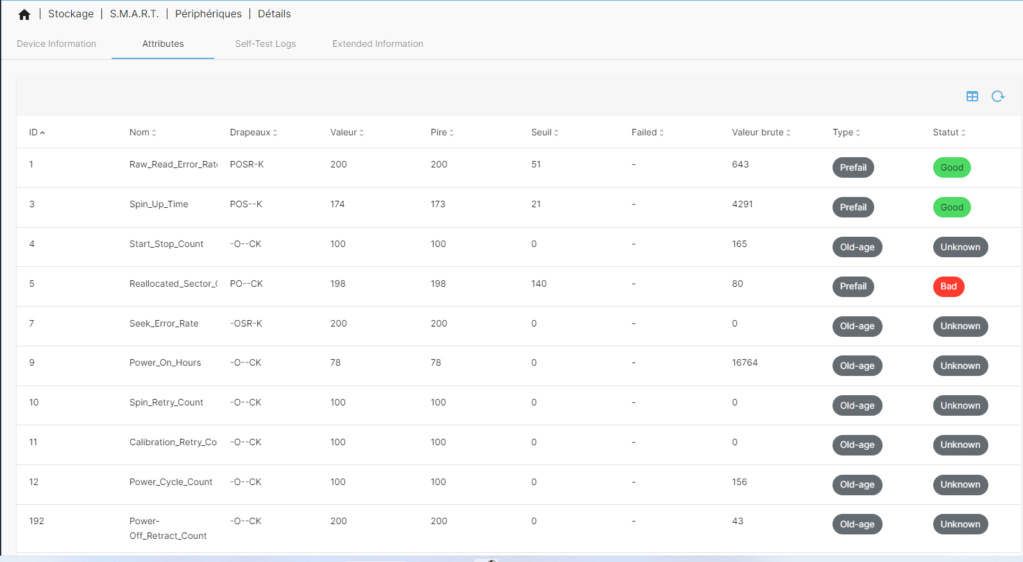

Je sais que l'un de mes HDD était un peu moyen (idem, toutes les infos en capture d'écran).

Solution :

Aucune pour le moment mais je tombe sur le sujet cité plus haut et j'ai pris la peine de faire toutes les commandes demandées au début du post, je vous mets l'ensemble ci-dessous.

Avant d'aller plus loin ou de tenter quoi que se soit, j'ai besoin d'un avis voir de tenter une reconstruction, mais je ne veux pas faire de bêtises, alors je viens vers vous.

Merci de votre aide par avance. Merci de votre aide par avance.

Pièces jointes :

Captures OMV :

Résultat du rapport smart sur le disque abîmé :

Code :

- smartctl 7.2 2020-12-30 r5155 [x86_64-linux-5.10.0-19-amd64] (local build)

- Copyright (C) 2002-20, Bruce Allen, Christian Franke, www.smartmontools.org

- === START OF INFORMATION SECTION ===

- Model Family: Western Digital Purple (Pro)

- Device Model: WDC WD20PURX-64P6ZY0

- Serial Number: WD-WCC4M7EPE5KH

- LU WWN Device Id: 5 0014ee 2b90d65df

- Firmware Version: 80.00A80

- User Capacity: 2,000,398,934,016 bytes [2.00 TB]

- Sector Sizes: 512 bytes logical, 4096 bytes physical

- Rotation Rate: 5400 rpm

- Device is: In smartctl database [for details use: -P show]

- ATA Version is: ACS-2 (minor revision not indicated)

- SATA Version is: SATA 3.0, 6.0 Gb/s (current: 6.0 Gb/s)

- Local Time is: Fri Dec 16 09:28:01 2022 CET

- SMART support is: Available - device has SMART capability.

- SMART support is: Enabled

- AAM feature is: Unavailable

- APM feature is: Unavailable

- Rd look-ahead is: Enabled

- Write cache is: Enabled

- DSN feature is: Unavailable

- ATA Security is: Disabled, NOT FROZEN [SEC1]

- Wt Cache Reorder: Enabled

- === START OF READ SMART DATA SECTION ===

- SMART overall-health self-assessment test result: PASSED

- General SMART Values:

- Offline data collection status: (0x82) Offline data collection activity

- was completed without error.

- Auto Offline Data Collection: Enabled.

- Self-test execution status: ( 0) The previous self-test routine completed

- without error or no self-test has ever

- been run.

- Total time to complete Offline

- data collection: (26280) seconds.

- Offline data collection

- capabilities: (0x7b) SMART execute Offline immediate.

- Auto Offline data collection on/off support.

- Suspend Offline collection upon new

- command.

- Offline surface scan supported.

- Self-test supported.

- Conveyance Self-test supported.

- Selective Self-test supported.

- SMART capabilities: (0x0003) Saves SMART data before entering

- power-saving mode.

- Supports SMART auto save timer.

- Error logging capability: (0x01) Error logging supported.

- General Purpose Logging supported.

- Short self-test routine

- recommended polling time: ( 2) minutes.

- Extended self-test routine

- recommended polling time: ( 266) minutes.

- Conveyance self-test routine

- recommended polling time: ( 5) minutes.

- SCT capabilities: (0x703d) SCT Status supported.

- SCT Error Recovery Control supported.

- SCT Feature Control supported.

- SCT Data Table supported.

- SMART Attributes Data Structure revision number: 16

- Vendor Specific SMART Attributes with Thresholds:

- ID# ATTRIBUTE_NAME FLAGS VALUE WORST THRESH FAIL RAW_VALUE

- 1 Raw_Read_Error_Rate POSR-K 200 200 051 - 643

- 3 Spin_Up_Time POS--K 174 173 021 - 4291

- 4 Start_Stop_Count -O--CK 100 100 000 - 165

- 5 Reallocated_Sector_Ct PO--CK 198 198 140 - 80

- 7 Seek_Error_Rate -OSR-K 200 200 000 - 0

- 9 Power_On_Hours -O--CK 078 078 000 - 16764

- 10 Spin_Retry_Count -O--CK 100 100 000 - 0

- 11 Calibration_Retry_Count -O--CK 100 100 000 - 0

- 12 Power_Cycle_Count -O--CK 100 100 000 - 156

- 192 Power-Off_Retract_Count -O--CK 200 200 000 - 43

- 193 Load_Cycle_Count -O--CK 200 200 000 - 215

- 194 Temperature_Celsius -O---K 128 101 000 - 19

- 196 Reallocated_Event_Count -O--CK 174 174 000 - 26

- 197 Current_Pending_Sector -O--CK 200 200 000 - 17

- 198 Offline_Uncorrectable ----CK 200 200 000 - 57

- 199 UDMA_CRC_Error_Count -O--CK 200 200 000 - 0

- 200 Multi_Zone_Error_Rate ---R-- 200 200 000 - 173

- ||||||_ K auto-keep

- |||||__ C event count

- ||||___ R error rate

- |||____ S speed/performance

- ||_____ O updated online

- |______ P prefailure warning

- General Purpose Log Directory Version 1

- SMART Log Directory Version 1 [multi-sector log support]

- Address Access R/W Size Description

- 0x00 GPL,SL R/O 1 Log Directory

- 0x01 SL R/O 1 Summary SMART error log

- 0x02 SL R/O 5 Comprehensive SMART error log

- 0x03 GPL R/O 6 Ext. Comprehensive SMART error log

- 0x06 SL R/O 1 SMART self-test log

- 0x07 GPL R/O 1 Extended self-test log

- 0x09 SL R/W 1 Selective self-test log

- 0x10 GPL R/O 1 NCQ Command Error log

- 0x11 GPL R/O 1 SATA Phy Event Counters log

- 0x21 GPL R/O 1 Write stream error log

- 0x22 GPL R/O 1 Read stream error log

- 0x80-0x9f GPL,SL R/W 16 Host vendor specific log

- 0xa0-0xa7 GPL,SL VS 16 Device vendor specific log

- 0xa8-0xb6 GPL,SL VS 1 Device vendor specific log

- 0xb7 GPL,SL VS 39 Device vendor specific log

- 0xbd GPL,SL VS 1 Device vendor specific log

- 0xc0 GPL,SL VS 1 Device vendor specific log

- 0xc1 GPL VS 93 Device vendor specific log

- 0xe0 GPL,SL R/W 1 SCT Command/Status

- 0xe1 GPL,SL R/W 1 SCT Data Transfer

- SMART Extended Comprehensive Error Log Version: 1 (6 sectors)

- Device Error Count: 526 (device log contains only the most recent 24 errors)

- CR = Command Register

- FEATR = Features Register

- COUNT = Count (was: Sector Count) Register

- LBA_48 = Upper bytes of LBA High/Mid/Low Registers ] ATA-8

- LH = LBA High (was: Cylinder High) Register ] LBA

- LM = LBA Mid (was: Cylinder Low) Register ] Register

- LL = LBA Low (was: Sector Number) Register ]

- DV = Device (was: Device/Head) Register

- DC = Device Control Register

- ER = Error register

- ST = Status register

- Powered_Up_Time is measured from power on, and printed as

- DDd+hh:mm:SS.sss where DD=days, hh=hours, mm=minutes,

- SS=sec, and sss=millisec. It "wraps" after 49.710 days.

- Error 526 [21] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 01 00 00 70 00 00 00 00 00 00 40 08 00:00:35.147 READ FPDMA QUEUED

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:34.383 SET FEATURES [Enable SATA feature]

- 27 00 00 00 00 00 00 00 00 00 00 e0 08 00:00:34.383 READ NATIVE MAX ADDRESS EXT [OBS-ACS-3]

- ec 00 00 00 00 00 00 00 00 00 00 a0 08 00:00:34.383 IDENTIFY DEVICE

- ef 00 03 00 46 00 00 00 00 00 00 a0 08 00:00:34.383 SET FEATURES [Set transfer mode]

- Error 525 [20] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 fe 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 01 00 00 68 00 00 00 00 00 00 40 08 00:00:34.185 READ FPDMA QUEUED

- ec 00 00 00 01 00 00 00 00 00 00 40 08 00:00:27.221 IDENTIFY DEVICE

- ef 00 05 00 fe 00 00 00 00 00 00 40 08 00:00:27.171 SET FEATURES [Enable APM]

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:27.170 SET FEATURES [Enable SATA feature]

- 27 00 00 00 00 00 00 00 00 00 00 e0 08 00:00:27.170 READ NATIVE MAX ADDRESS EXT [OBS-ACS-3]

- Error 524 [19] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 00 08 00 80 00 00 00 00 00 08 40 08 00:00:26.986 READ FPDMA QUEUED

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:26.986 SET FEATURES [Enable SATA feature]

- 27 00 00 00 00 00 00 00 00 00 00 e0 08 00:00:26.986 READ NATIVE MAX ADDRESS EXT [OBS-ACS-3]

- ec 00 00 00 00 00 00 00 00 00 00 a0 08 00:00:26.986 IDENTIFY DEVICE

- ef 00 03 00 46 00 00 00 00 00 00 a0 08 00:00:26.986 SET FEATURES [Set transfer mode]

- Error 523 [18] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 00 08 00 28 00 00 00 00 00 08 40 08 00:00:26.290 READ FPDMA QUEUED

- 60 00 08 00 88 00 00 00 00 00 00 40 08 00:00:26.236 READ FPDMA QUEUED

- 60 00 08 00 80 00 00 e8 e0 88 a0 40 08 00:00:26.235 READ FPDMA QUEUED

- 60 00 08 00 68 00 00 e8 e0 88 00 40 08 00:00:26.208 READ FPDMA QUEUED

- ec 00 00 00 01 00 00 00 00 00 00 00 08 00:00:26.206 IDENTIFY DEVICE

- Error 522 [17] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 01 00 00 e0 00 00 00 00 00 00 40 08 00:00:25.995 READ FPDMA QUEUED

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:25.405 SET FEATURES [Enable SATA feature]

- 27 00 00 00 00 00 00 00 00 00 00 e0 08 00:00:25.405 READ NATIVE MAX ADDRESS EXT [OBS-ACS-3]

- ec 00 00 00 00 00 00 00 00 00 00 a0 08 00:00:25.404 IDENTIFY DEVICE

- ef 00 03 00 46 00 00 00 00 00 00 a0 08 00:00:25.404 SET FEATURES [Set transfer mode]

- Error 521 [16] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 00 08 00 e0 00 00 00 00 00 08 40 08 00:00:25.237 READ FPDMA QUEUED

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:25.237 SET FEATURES [Enable SATA feature]

- 27 00 00 00 00 00 00 00 00 00 00 e0 08 00:00:25.237 READ NATIVE MAX ADDRESS EXT [OBS-ACS-3]

- ec 00 00 00 00 00 00 00 00 00 00 a0 08 00:00:25.236 IDENTIFY DEVICE

- ef 00 03 00 46 00 00 00 00 00 00 a0 08 00:00:25.236 SET FEATURES [Set transfer mode]

- Error 520 [15] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 00 08 00 d8 00 00 00 00 00 08 40 08 00:00:25.070 READ FPDMA QUEUED

- 60 00 08 00 d0 00 00 00 00 00 00 40 08 00:00:25.038 READ FPDMA QUEUED

- 60 00 08 00 c8 00 00 e8 e0 88 a0 40 08 00:00:25.037 READ FPDMA QUEUED

- 60 00 08 00 c0 00 00 e8 e0 88 00 40 08 00:00:25.006 READ FPDMA QUEUED

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:24.470 SET FEATURES [Enable SATA feature]

- Error 519 [14] occurred at disk power-on lifetime: 16764 hours (698 days + 12 hours)

- When the command that caused the error occurred, the device was active or idle.

- After command completion occurred, registers were:

- ER -- ST COUNT LBA_48 LH LM LL DV DC

- -- -- -- == -- == == == -- -- -- -- --

- 40 -- 51 00 00 00 00 00 00 00 09 40 00 Error: UNC at LBA = 0x00000009 = 9

- Commands leading to the command that caused the error were:

- CR FEATR COUNT LBA_48 LH LM LL DV DC Powered_Up_Time Command/Feature_Name

- -- == -- == -- == == == -- -- -- -- -- --------------- --------------------

- 60 00 08 00 20 00 00 00 00 00 08 40 08 00:00:24.306 READ FPDMA QUEUED

- ef 00 10 00 02 00 00 00 00 00 00 a0 08 00:00:24.306 SET FEATURES [Enable SATA feature]

- 27 00 00 00 00 00 00 00 00 00 00 e0 08 00:00:24.306 READ NATIVE MAX ADDRESS EXT [OBS-ACS-3]

- ec 00 00 00 00 00 00 00 00 00 00 a0 08 00:00:24.305 IDENTIFY DEVICE

- ef 00 03 00 46 00 00 00 00 00 00 a0 08 00:00:24.305 SET FEATURES [Set transfer mode]

- SMART Extended Self-test Log Version: 1 (1 sectors)

- Num Test_Description Status Remaining LifeTime(hours) LBA_of_first_error

- # 1 Short offline Completed without error 00% 3664 -

- SMART Selective self-test log data structure revision number 1

- SPAN MIN_LBA MAX_LBA CURRENT_TEST_STATUS

- 1 0 0 Not_testing

- 2 0 0 Not_testing

- 3 0 0 Not_testing

- 4 0 0 Not_testing

- 5 0 0 Not_testing

- Selective self-test flags (0x0):

- After scanning selected spans, do NOT read-scan remainder of disk.

- If Selective self-test is pending on power-up, resume after 0 minute delay.

- SCT Status Version: 3

- SCT Version (vendor specific): 258 (0x0102)

- Device State: Active (0)

- Current Temperature: 19 Celsius

- Power Cycle Min/Max Temperature: 18/19 Celsius

- Lifetime Min/Max Temperature: 2/47 Celsius

- Under/Over Temperature Limit Count: 0/0

- Vendor specific:

- 01 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00

- 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00

- SCT Temperature History Version: 2

- Temperature Sampling Period: 1 minute

- Temperature Logging Interval: 1 minute

- Min/Max recommended Temperature: 0/60 Celsius

- Min/Max Temperature Limit: -41/85 Celsius

- Temperature History Size (Index): 478 (423)

- Index Estimated Time Temperature Celsius

- 424 2022-12-16 01:31 28 *********

- ... ..(173 skipped). .. *********

- 120 2022-12-16 04:25 28 *********

- 121 2022-12-16 04:26 ? -

- 122 2022-12-16 04:27 18 -

- 123 2022-12-16 04:28 18 -

- 124 2022-12-16 04:29 19 -

- 125 2022-12-16 04:30 19 -

- 126 2022-12-16 04:31 20 *

- 127 2022-12-16 04:32 20 *

- 128 2022-12-16 04:33 21 **

- ... ..( 2 skipped). .. **

- 131 2022-12-16 04:36 21 **

- 132 2022-12-16 04:37 22 ***

- 133 2022-12-16 04:38 22 ***

- 134 2022-12-16 04:39 23 ****

- 135 2022-12-16 04:40 23 ****

- 136 2022-12-16 04:41 23 ****

- 137 2022-12-16 04:42 24 *****

- ... ..( 4 skipped). .. *****

- 142 2022-12-16 04:47 24 *****

- 143 2022-12-16 04:48 25 ******

- ... ..( 4 skipped). .. ******

- 148 2022-12-16 04:53 25 ******

- 149 2022-12-16 04:54 26 *******

- ... ..( 3 skipped). .. *******

- 153 2022-12-16 04:58 26 *******

- 154 2022-12-16 04:59 27 ********

- ... ..( 11 skipped). .. ********

- 166 2022-12-16 05:11 27 ********

- 167 2022-12-16 05:12 ? -

- 168 2022-12-16 05:13 28 *********

- ... ..( 5 skipped). .. *********

- 174 2022-12-16 05:19 28 *********

- 175 2022-12-16 05:20 ? -

- 176 2022-12-16 05:21 28 *********

- 177 2022-12-16 05:22 27 ********

- ... ..( 25 skipped). .. ********

- 203 2022-12-16 05:48 27 ********

- 204 2022-12-16 05:49 28 *********

- ... ..( 8 skipped). .. *********

- 213 2022-12-16 05:58 28 *********

- 214 2022-12-16 05:59 ? -

- 215 2022-12-16 06:00 18 -

- 216 2022-12-16 06:01 18 -

- 217 2022-12-16 06:02 19 -

- 218 2022-12-16 06:03 28 *********

- ... ..(204 skipped). .. *********

- 423 2022-12-16 09:28 28 *********

- SCT Error Recovery Control:

- Read: 70 (7.0 seconds)

- Write: 70 (7.0 seconds)

- Device Statistics (GP/SMART Log 0x04) not supported

- Pending Defects log (GP Log 0x0c) not supported

- SATA Phy Event Counters (GP Log 0x11)

- ID Size Value Description

- 0x0001 2 0 Command failed due to ICRC error

- 0x0002 2 0 R_ERR response for data FIS

- 0x0003 2 0 R_ERR response for device-to-host data FIS

- 0x0004 2 0 R_ERR response for host-to-device data FIS

- 0x0005 2 0 R_ERR response for non-data FIS

- 0x0006 2 0 R_ERR response for device-to-host non-data FIS

- 0x0007 2 0 R_ERR response for host-to-device non-data FIS

- 0x0008 2 0 Device-to-host non-data FIS retries

- 0x0009 2 4 Transition from drive PhyRdy to drive PhyNRdy

- 0x000a 2 4 Device-to-host register FISes sent due to a COMRESET

- 0x000b 2 0 CRC errors within host-to-device FIS

- 0x000f 2 0 R_ERR response for host-to-device data FIS, CRC

- 0x0012 2 0 R_ERR response for host-to-device non-data FIS, CRC

- 0x8000 4 207 Vendor specific

|

Résultat des commandes obtenus par connexion SSH :

Code :

- cat /proc/mdstat mdadm --detail /dev/md127

- mdadm --examine --scan

- mdadm --examine /dev/sdb

- mdadm --examine /dev/sdc

- mdadm --examine /dev/sdd

- mdadm --examine /dev/sde

- mdadm --examine /dev/sdf

- mdadm --examine /dev/sdg

|

Code :

- root@NAS-Clauce:~# cat /proc/mdstat

- Personalities : [linear] [multipath] [raid0] [raid1] [raid6] [raid5] [raid4] [raid10]

- md127 : inactive sdf[3](S) sdd[1](S) sdg[4](S) sdc[0](S) sdb[5](S)

- 9766912440 blocks super 1.2

- unused devices: <none>

- root@NAS-Clauce:~# fdisk -l

- Disk /dev/sda: 111,79 GiB, 120034123776 bytes, 234441648 sectors

- Disk model: CT120BX500SSD1

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 512 bytes

- I/O size (minimum/optimal): 512 bytes / 512 bytes

- Disklabel type: dos

- Disk identifier: 0xcbe3b062

- Device Boot Start End Sectors Size Id Type

- /dev/sda1 * 2048 232441855 232439808 110,8G 83 Linux

- /dev/sda2 232443902 234440703 1996802 975M 5 Extended

- /dev/sda5 232443904 234440703 1996800 975M 82 Linux swap / Solaris

- Disk /dev/sdg: 1,82 TiB, 2000398934016 bytes, 3907029168 sectors

- Disk model: ST2000DL003-9VT1

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 4096 bytes

- I/O size (minimum/optimal): 4096 bytes / 4096 bytes

- Disk /dev/sdc: 1,82 TiB, 2000398934016 bytes, 3907029168 sectors

- Disk model: ST2000DL003-9VT1

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 512 bytes

- I/O size (minimum/optimal): 512 bytes / 512 bytes

- Disk /dev/sdf: 1,82 TiB, 2000398934016 bytes, 3907029168 sectors

- Disk model: WDC WD20PURX-64P

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 4096 bytes

- I/O size (minimum/optimal): 4096 bytes / 4096 bytes

- Disk /dev/sdb: 1,82 TiB, 2000398934016 bytes, 3907029168 sectors

- Disk model: WDC WD20EFRX-68E

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 4096 bytes

- I/O size (minimum/optimal): 4096 bytes / 4096 bytes

- Disk /dev/sdd: 1,82 TiB, 2000398934016 bytes, 3907029168 sectors

- Disk model: WDC WD20EFRX-68E

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 4096 bytes

- I/O size (minimum/optimal): 4096 bytes / 4096 bytes

- Disk /dev/sde: 1,82 TiB, 2000398934016 bytes, 3907029168 sectors

- Disk model: WDC WD20PURX-64P

- Units: sectors of 1 * 512 = 512 bytes

- Sector size (logical/physical): 512 bytes / 4096 bytes

- I/O size (minimum/optimal): 4096 bytes / 4096 bytes

- root@NAS-Clauce:~# lsblk -o size,name,fstype,label,mountpoint

- SIZE NAME FSTYPE LABEL MOUNTPOINT

- 111,8G sda

- 110,8G ├─sda1 ext4 /

- 1K ├─sda2

- 975M └─sda5 swap [SWAP]

- 1,8T sdb linux_raid_member NAS-Clauce.local:nAsRaid6

- 1,8T sdc linux_raid_member NAS-Clauce.local:nAsRaid6

- 1,8T sdd linux_raid_member NAS-Clauce.local:nAsRaid6

- 1,8T sde

- 1,8T sdf linux_raid_member NAS-Clauce.local:nAsRaid6

- 1,8T sdg linux_raid_member NAS-Clauce.local:nAsRaid6

- root@NAS-Clauce:~# mdadm --detail /dev/md127

- /dev/md127:

- Version : 1.2

- Raid Level : raid0

- Total Devices : 5

- Persistence : Superblock is persistent

- State : inactive

- Working Devices : 5

- Name : NAS-Clauce.local:nAsRaid6

- UUID : e2c2cb4c:3016aaf3:85eb9454:34697d09

- Events : 76091

- Number Major Minor RaidDevice

- - 8 32 - /dev/sdc

- - 8 80 - /dev/sdf

- - 8 48 - /dev/sdd

- - 8 16 - /dev/sdb

- - 8 96 - /dev/sdg

- root@NAS-Clauce:~# mdadm --examine --scan

- ARRAY /dev/md/nAsRaid6 metadata=1.2 UUID=e2c2cb4c:3016aaf3:85eb9454:34697d09 name=NAS-Clauce.local:nAsRaid6

- root@NAS-Clauce:~# mdadm --examine /dev/sdb

- mdadm --examine /dev/sdc

- mdadm --examine /dev/sdd

- mdadm --examine /dev/sde

- mdadm --examine /dev/sdf

- mdadm --examine /dev/sdg

- /dev/sdb:

- Magic : a92b4efc

- Version : 1.2

- Feature Map : 0x1

- Array UUID : e2c2cb4c:3016aaf3:85eb9454:34697d09

- Name : NAS-Clauce.local:nAsRaid6

- Creation Time : Thu Sep 10 00:54:20 2020

- Raid Level : raid6

- Raid Devices : 6

- Avail Dev Size : 3906764976 (1862.89 GiB 2000.26 GB)

- Array Size : 7813529600 (7451.56 GiB 8001.05 GB)

- Used Dev Size : 3906764800 (1862.89 GiB 2000.26 GB)

- Data Offset : 264192 sectors

- Super Offset : 8 sectors

- Unused Space : before=264112 sectors, after=176 sectors

- State : clean

- Device UUID : 30619ac9:18c1234f:bab720a7:03821dfd

- Internal Bitmap : 8 sectors from superblock

- Update Time : Wed Nov 23 18:00:46 2022

- Bad Block Log : 512 entries available at offset 16 sectors

- Checksum : ec46047a - correct

- Events : 76091

- Layout : left-symmetric

- Chunk Size : 512K

- Device Role : Active device 5

- Array State : AAAAAA ('A' == active, '.' == missing, 'R' == replacing)

- /dev/sdc:

- Magic : a92b4efc

- Version : 1.2

- Feature Map : 0x1

- Array UUID : e2c2cb4c:3016aaf3:85eb9454:34697d09

- Name : NAS-Clauce.local:nAsRaid6

- Creation Time : Thu Sep 10 00:54:20 2020

- Raid Level : raid6

- Raid Devices : 6

- Avail Dev Size : 3906764976 (1862.89 GiB 2000.26 GB)

- Array Size : 7813529600 (7451.56 GiB 8001.05 GB)

- Used Dev Size : 3906764800 (1862.89 GiB 2000.26 GB)

- Data Offset : 264192 sectors

- Super Offset : 8 sectors

- Unused Space : before=264112 sectors, after=176 sectors

- State : clean

- Device UUID : 9a8b8a48:3f16a7ea:3ba4ce98:d62c82c2

- Internal Bitmap : 8 sectors from superblock

- Update Time : Wed Nov 23 18:00:46 2022

- Bad Block Log : 512 entries available at offset 16 sectors

- Checksum : bdcc1b5a - correct

- Events : 76091

- Layout : left-symmetric

- Chunk Size : 512K

- Device Role : Active device 0

- Array State : AAAAAA ('A' == active, '.' == missing, 'R' == replacing)

- /dev/sdd:

- Magic : a92b4efc

- Version : 1.2

- Feature Map : 0x1

- Array UUID : e2c2cb4c:3016aaf3:85eb9454:34697d09

- Name : NAS-Clauce.local:nAsRaid6

- Creation Time : Thu Sep 10 00:54:20 2020

- Raid Level : raid6

- Raid Devices : 6

- Avail Dev Size : 3906764976 (1862.89 GiB 2000.26 GB)

- Array Size : 7813529600 (7451.56 GiB 8001.05 GB)

- Used Dev Size : 3906764800 (1862.89 GiB 2000.26 GB)

- Data Offset : 264192 sectors

- Super Offset : 8 sectors

- Unused Space : before=264112 sectors, after=176 sectors

- State : clean

- Device UUID : 0a8d8147:3bf0390f:40a06163:22cab317

- Internal Bitmap : 8 sectors from superblock

- Update Time : Wed Nov 23 18:00:46 2022

- Bad Block Log : 512 entries available at offset 16 sectors

- Checksum : 11a9017 - correct

- Events : 76091

- Layout : left-symmetric

- Chunk Size : 512K

- Device Role : Active device 1

- Array State : AAAAAA ('A' == active, '.' == missing, 'R' == replacing)

- mdadm: No md superblock detected on /dev/sde.

- /dev/sdf:

- Magic : a92b4efc

- Version : 1.2

- Feature Map : 0x1

- Array UUID : e2c2cb4c:3016aaf3:85eb9454:34697d09

- Name : NAS-Clauce.local:nAsRaid6

- Creation Time : Thu Sep 10 00:54:20 2020

- Raid Level : raid6

- Raid Devices : 6

- Avail Dev Size : 3906764976 (1862.89 GiB 2000.26 GB)

- Array Size : 7813529600 (7451.56 GiB 8001.05 GB)

- Used Dev Size : 3906764800 (1862.89 GiB 2000.26 GB)

- Data Offset : 264192 sectors

- Super Offset : 8 sectors

- Unused Space : before=264112 sectors, after=176 sectors

- State : clean

- Device UUID : 5a9a2cbe:f33d9c52:b4b2b1e0:09620b7f

- Internal Bitmap : 8 sectors from superblock

- Update Time : Wed Nov 23 18:00:46 2022

- Bad Block Log : 512 entries available at offset 16 sectors

- Checksum : 9fcf957d - correct

- Events : 76091

- Layout : left-symmetric

- Chunk Size : 512K

- Device Role : Active device 3

- Array State : AAAAAA ('A' == active, '.' == missing, 'R' == replacing)

- /dev/sdg:

- Magic : a92b4efc

- Version : 1.2

- Feature Map : 0x1

- Array UUID : e2c2cb4c:3016aaf3:85eb9454:34697d09

- Name : NAS-Clauce.local:nAsRaid6

- Creation Time : Thu Sep 10 00:54:20 2020

- Raid Level : raid6

- Raid Devices : 6

- Avail Dev Size : 3906764976 (1862.89 GiB 2000.26 GB)

- Array Size : 7813529600 (7451.56 GiB 8001.05 GB)

- Used Dev Size : 3906764800 (1862.89 GiB 2000.26 GB)

- Data Offset : 264192 sectors

- Super Offset : 8 sectors

- Unused Space : before=264112 sectors, after=176 sectors

- State : clean

- Device UUID : f928ff46:faf937ea:96517aa2:f85740bf

- Internal Bitmap : 8 sectors from superblock

- Update Time : Wed Nov 23 18:00:46 2022

- Bad Block Log : 512 entries available at offset 16 sectors

- Checksum : c23b74f5 - correct

- Events : 76091

- Layout : left-symmetric

- Chunk Size : 512K

- Device Role : Active device 4

- Array State : AAAAAA ('A' == active, '.' == missing, 'R' == replacing)

|

Message édité par tibodreep le 16-12-2022 à 09:56:41

|